Возможно, вы уже протестировали механизмы генеративного искусственного интеллекта, такие как ChatGPT и Google Bard. Но хотя доступ к этим инструментам в облаке популярен, вы также можете установить их локально на свой компьютер. В этом есть некоторые реальные преимущества: это, конечно, более конфиденциально, и вы не получите никаких предупреждений о том, что ИИ перегружен или недоступен. Кроме того, это просто круто.

Для начала вам понадобится программа для запуска ИИ, а также вам понадобится модель большого языка (или LLM) для генерации ответов. Эти LLM лежат в основе генераторов текста AI. GPT-4 — это последняя версия, лежащая в основе ChatGPT, и теперь Google вытеснил Gemini в качестве новой и улучшенной LLM, работающей на базе Google Bard.

Если вы никогда раньше не слышали термин LLM, вы явно не читали наш полный глоссарий по искусственному интеллекту. Чтобы полностью их понять, требуется определенный уровень научных и математических знаний, но, по сути, LLM обучаются на огромных объемах выборочных данных и учатся распознавать связи между словами и предложениями (т. е. какие слова обычно следуют друг за другом).

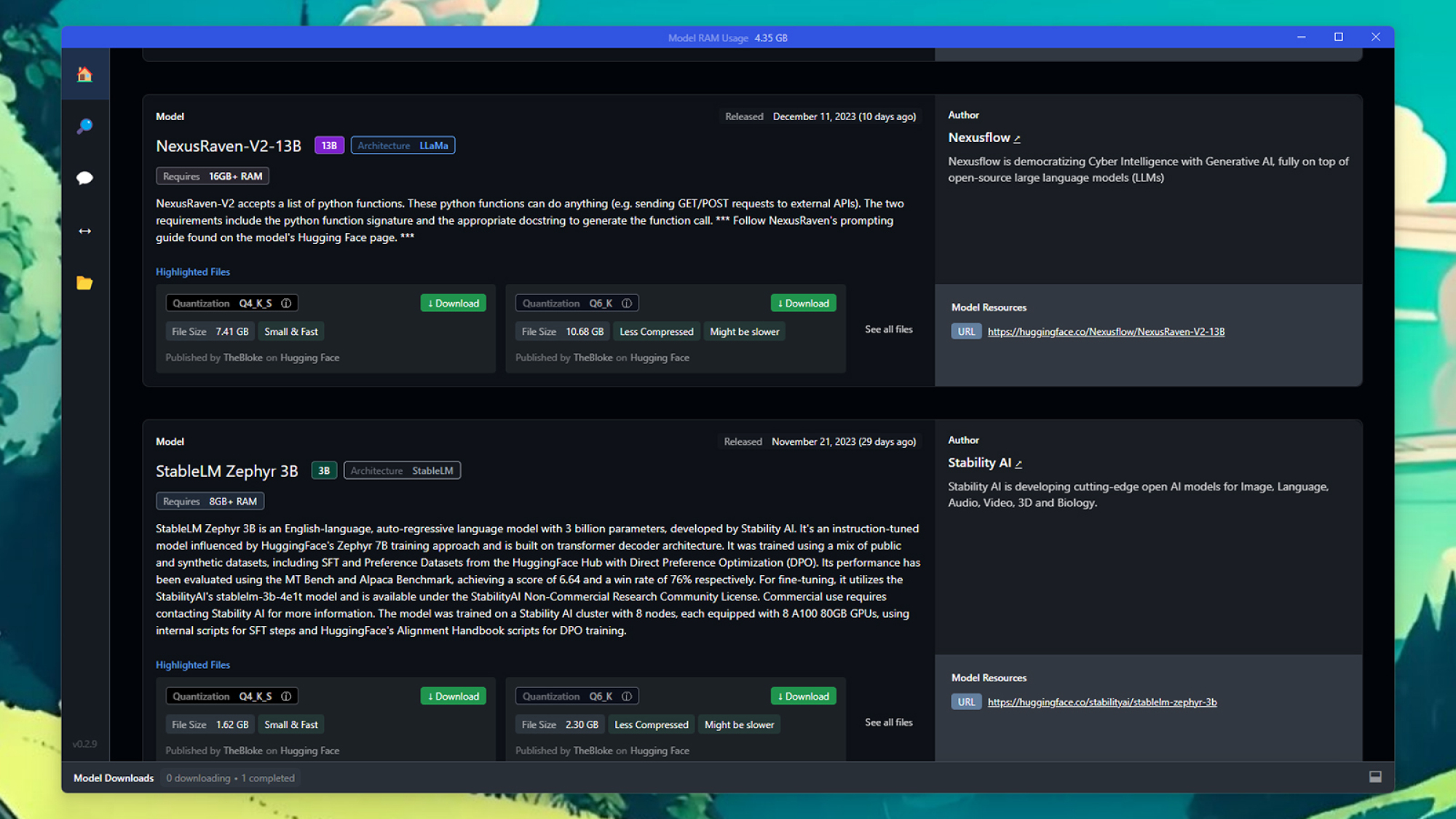

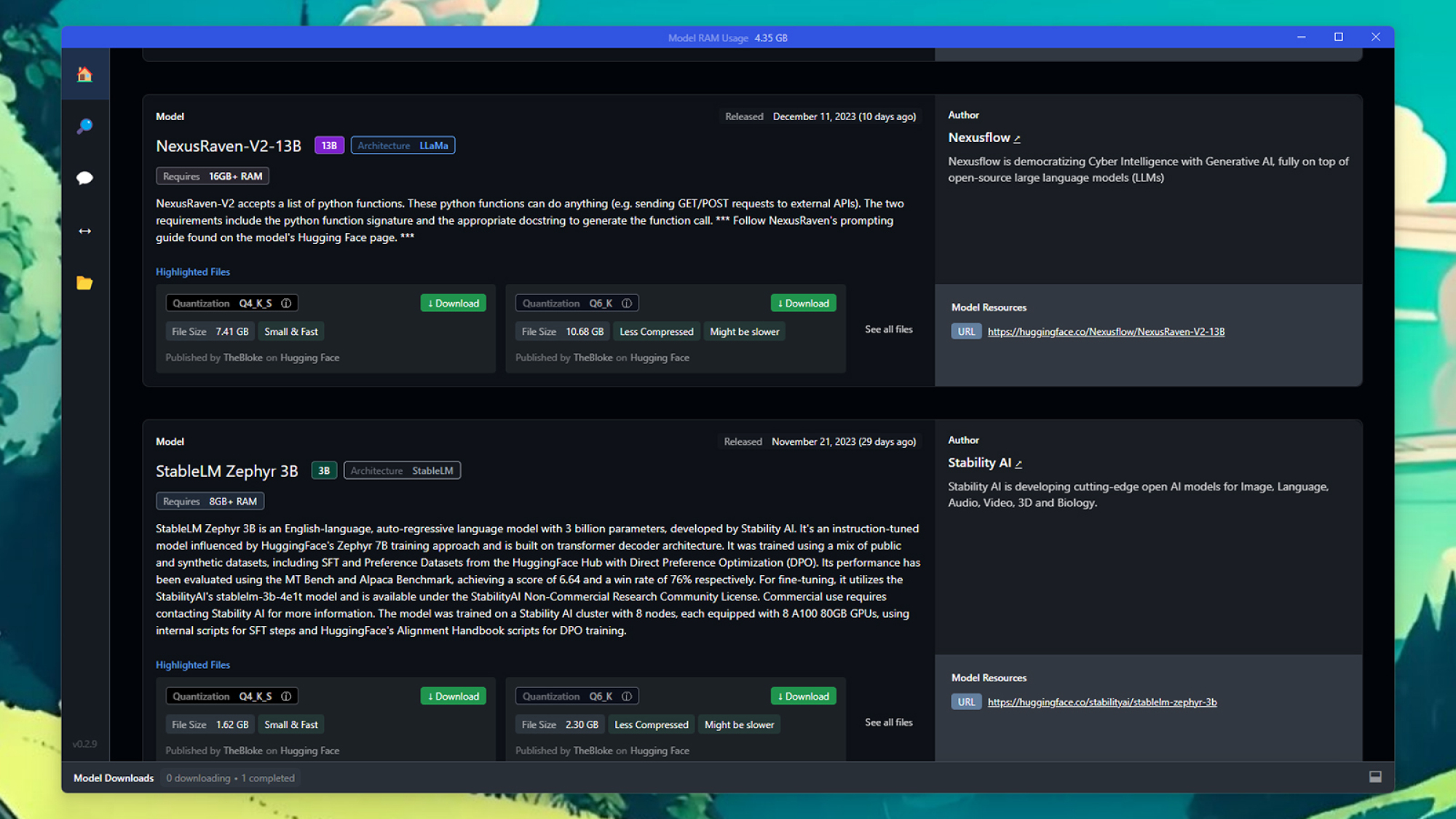

Существует несколько моделей ИИ, которые можно установить локально. Фото: Lifehacker

Существует несколько моделей ИИ, которые можно установить локально. Фото: Lifehacker

Проще говоря, LLM — это двигатели автокоррекции с наддувом. На самом деле они ничего не «знают», но понимают, как слова должны сочетаться друг с другом, чтобы звучать естественно и иметь смысл. На достаточно высоком уровне это начинает выглядеть так, будто вы разговариваете с настоящим человеком. Это еще не все, но суть вы поняли.

Когда дело доходит до запуска собственных программ LLM, вам не обязательно быть огромной компанией или исследовательской организацией, чтобы получить к ним доступ: существует несколько общедоступных программ, в том числе выпущенный Meta под названием LLaMa; другие были разработаны исследователями и волонтерами. Основная идея заключается в том, что общедоступные программы LLM помогут стимулировать инновации и повысить прозрачность.

Для целей этого руководства мы собираемся использовать LM Studio, чтобы показать вам, как установить LLM локально. Это один из лучших вариантов работы (хотя есть и немало других). Его можно использовать бесплатно, и его можно настроить в системах Windows, macOS и Linux.

Как установить локальный LLM

Первым делом нужно скачать LM Studio с официального сайта, учитывая минимальные системные требования: работа LLM довольно требовательна, поэтому для этого вам понадобится довольно мощный компьютер. ПК с Windows или Linux, поддерживающие AVX2 (обычно на более новых машинах), и компьютеры Apple Silicon Mac с macOS 13.6 или новее будут работать, рекомендуется не менее 16 ГБ ОЗУ. На ПК также рекомендуется иметь как минимум 6 ГБ видеопамяти.

Когда программное обеспечение будет запущено, вам нужно будет найти LLM для загрузки и использования – вы не сможете этого сделать. многое сделать без него. Привлекательность LM Studio отчасти заключается в том, что она рекомендует «новые и заслуживающие внимания» LLM на первом экране приложения, поэтому, если вы понятия не имеете, какой LLM вам нужен, вы можете выбрать его здесь.

<р>Вы обнаружите, что LLM различаются по размеру, сложности, источникам данных, назначению и скорости: нет правильного или неправильного ответа, какой из них использовать, но на таких сайтах, как Reddit и Hugging Face, есть много информации. если вы хотите провести небольшое исследование. Как и следовало ожидать, файлы LLM могут иметь размер в несколько гигабайт, поэтому вы можете выполнять фоновое чтение, пока ждете загрузку.

LM Studio может помочь вам найти LLM для использования. Фото: Lifehacker

Если вы видите понравившийся вам LLM на главном экране, просто нажмите «Загрузить». В противном случае вы можете запустить поиск или вставить URL-адрес в поле вверху. Вы сможете увидеть размер каждого LLM, чтобы оценить время загрузки, а также дату последнего обновления. Также можно отфильтровать результаты, чтобы увидеть модели, которые загружались чаще всего.

Вы можете установить столько LLM, сколько захотите (при наличии места), но если в вашей системе есть хотя бы один, они отобразятся на панели «Мои модели». (Нажмите значок папки слева, чтобы перейти к ней.) Отсюда вы можете просмотреть информацию о каждой установленной вами модели, проверить наличие обновлений и удалить модели.

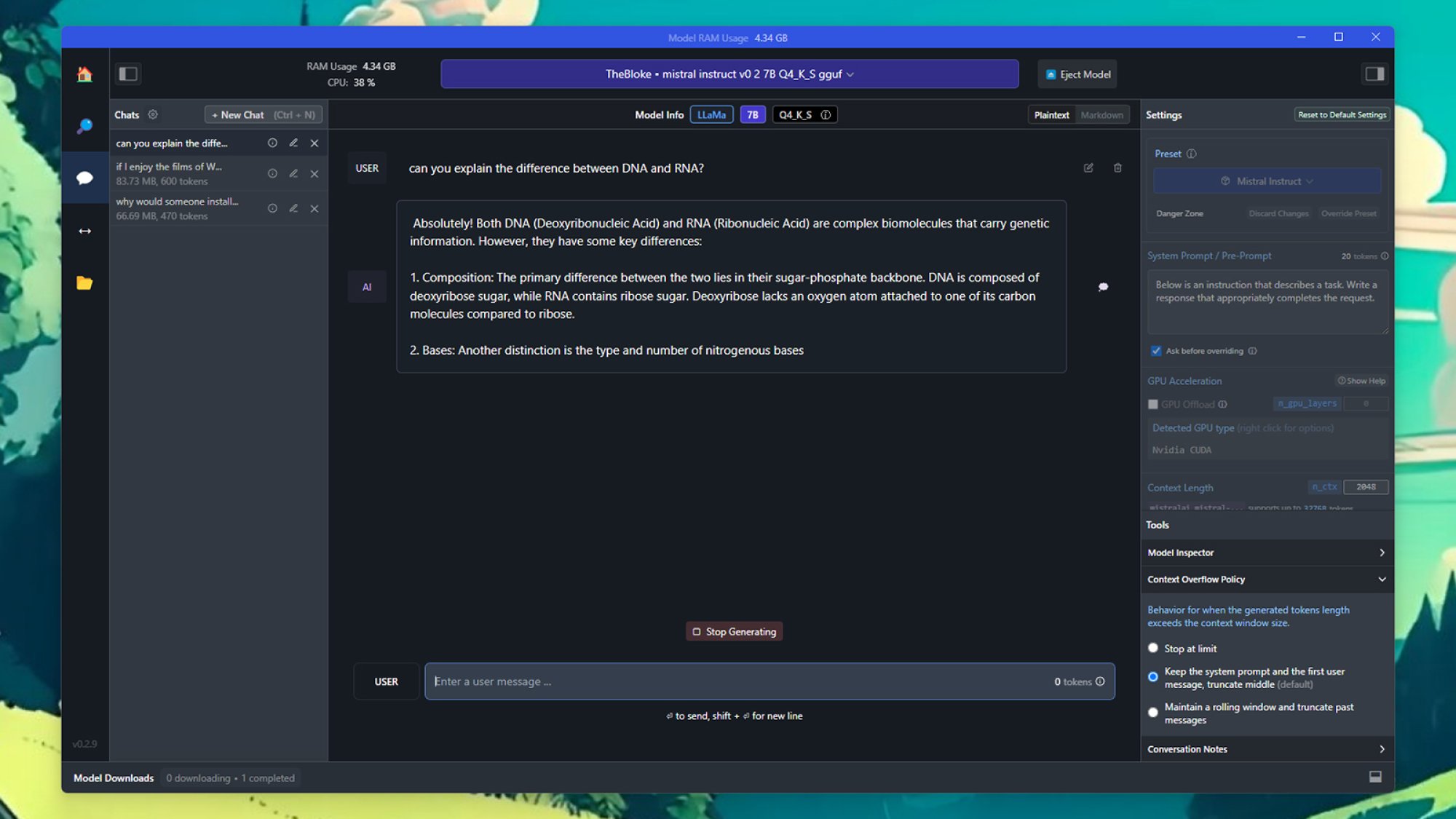

Чтобы начать подсказки, откройте панель AI Chat с помощью значка речевого пузыря слева. Выберите модель, которую хотите использовать, вверху, затем введите запрос в поле сообщения пользователя внизу и нажмите Enter. Вид возвращаемых результатов будет вам знаком, если вы раньше использовали LLM, например ChatGPT.

The система подсказок и ответов аналогична ChatGPT или Bard. Фото: Lifehacker

The система подсказок и ответов аналогична ChatGPT или Bard. Фото: Lifehacker

С правой стороны вы можете управлять различными настройками, связанными с LLM, в том числе тем, как обрабатываются более длинные ответы и какая часть обработки переносится на графический процессор вашей системы. Также имеется поле для «предварительного запроса». Например, вы можете указать LLM всегда отвечать определенным тоном или языком.

Нажмите кнопку Новый чат. слева, если вы хотите начать новый разговор, а ваши предыдущие чаты сохраняются внизу на случай, если вам понадобится вернуться к ним. Всякий раз, когда генерация определенного ответа завершается, вам предоставляется возможность сделать снимок экрана, скопировать текст или повторно создать другой ответ из того же запроса.

Вот и все! Вы уже работаете с местными LLM. Существуют всевозможные возможности, которые вы можете изучить с точки зрения разработки LLM, и подсказки, если вы хотите копнуть глубже, но основы нетрудно понять, а LM Studio делает процесс установки очень простым, даже если вы полный новичок. .

lifehacker.com